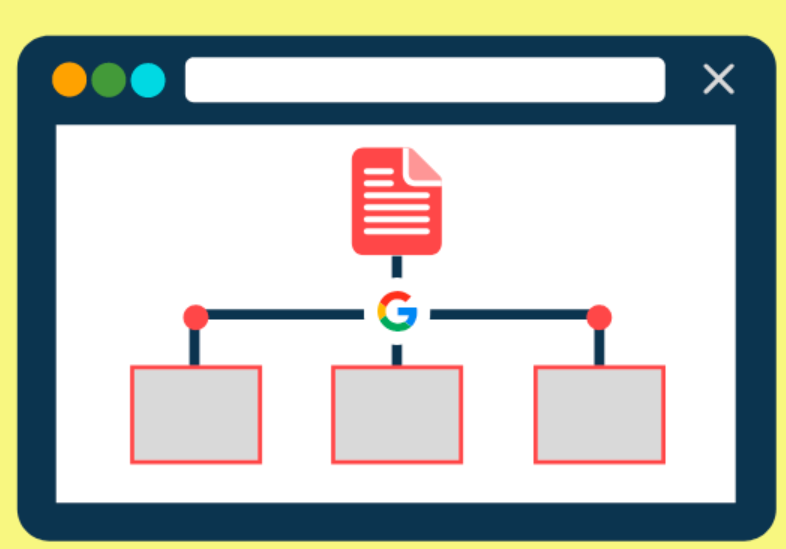

網絡爬蟲,通常被稱為蜘蛛或機器人,是自動瀏覽互聯網頁面以收集信息的程序。搜索引擎利用這些爬蟲來發掘內容,并將其納入索引,即存儲在龐大數據庫中的信息。這些程序通過跟隨網站上的鏈接來發現內容。然而,這個過程并不總是暢通無阻,有時會出現所謂的抓取錯誤。

那么,什么是抓取錯誤呢?簡單來說,抓取錯誤發生在搜索引擎的爬取工具無法正常訪問網頁的時候。在這種情況下,像Google這樣的搜索引擎無法充分理解和探索網站的內容或結構。這無疑是一個問題,因為抓取錯誤可能會阻止網頁被搜索到,進而影響到網頁被編入索引、出現在搜索結果中,以及為網站帶來免費的流量。

Google將抓取錯誤分為兩大類:網站錯誤和URL錯誤。下面我們將詳細探討這兩種錯誤。

首先是網站錯誤,這類錯誤可能會影響整個網站的抓取。常見的問題包括服務器錯誤、DNS錯誤和robots.txt錯誤。

服務器錯誤發生當服務器無法正常加載頁面,通常表現為5xx HTTP狀態代碼。具體包括:

- 內部服務器錯誤(500):服務器無法處理請求,有時也可能是當無法獲取更具體錯誤信息時觸發。

- 網關錯誤(502):作為網關的服務器收到了無效的響應。

- 服務不可用錯誤(503):服務器當前不可用,通常在服務器正在進行維護或更新時出現。

- 網關超時錯誤(504):作為網關的服務器沒有在預期時間內收到響應,這可能是由于網站流量過大造成。

當搜索引擎頻繁遇到5xx錯誤時,它們會減慢對網站的抓取速度。這意味著Google等搜索引擎可能無法發現并索引網站的所有內容。更嚴重的是,Google可能會從其索引中移除那些經常出現5xx問題的網址。因此,使用站點審核來跟蹤任何5xx錯誤是非常必要的。

DNS錯誤是指搜索引擎無法連接到網站的域。DNS通過將域名與IP地址相匹配,使得人們和計算機可以更輕松地在網絡上相互通信。如果沒有DNS,我們將不得不手動輸入網站的IP地址來訪問它們,而不是使用URL。DNS錯誤相對較少見,但可能會出現以下情況:

- DNS超時:DNS服務器沒有及時響應搜索引擎的請求。

- DNS查找失敗:搜索引擎無法訪問網站,因為DNS服務器找不到域名。

Robots.txt錯誤發生在搜索引擎無法訪問網站的robots.txt文件時。這個文件告訴搜索引擎哪些頁面可以抓取,哪些不可以。robots.txt文件主要包括三部分:

- 用戶代理:標識爬蟲的行,空格代表所有搜索引擎機器人適用。

- 禁止/允許:指示搜索引擎機器人是否可以抓取網站或其部分內容。

- 站點地圖:指示網站地圖位置的行,幫助爬蟲更快地發現和理解網站結構。

URL錯誤則僅影響網站上特定頁面的可抓取性。

404錯誤是最常見的URL錯誤之一,意味著搜索引擎機器人無法找到該URL。這可能發生在:

- 您更改了頁面的URL,但未更新指向舊鏈接的引用。

- 您從網站中刪除了頁面或文章,但未設置重定向。

- 您的鏈接已損壞,例如URL中存在錯誤。

如今,許多公司都使用自定義404頁面來改善用戶體驗,并與網站的設計和品牌保持一致。

- 聯系我們

-

- 聯系方式:13760637467

- QQ:1638373149

- 郵箱:1638373149@qq.com

- 地址:廣東省廣州市天河區豐興廣場A座2511室